windows下如何通过Ollama部署本地大模型

编辑

59

2025-03-20

安装

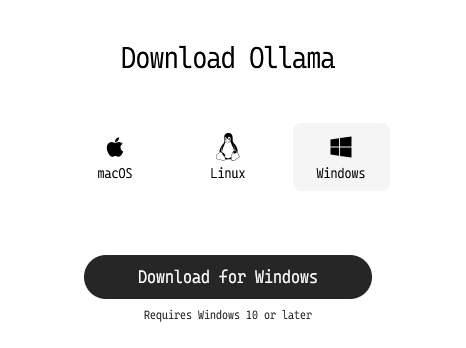

访问 Ollama官网:https://ollama.com/ 并根据页面提示进行下载。

根据安装包提示进行安装。或查看windows下详细安装教程

导入模型

选择模型: Ollama 支持多种流行的 LLMs,例如 deepseek-r1、QWQ 和 Llama3.3。你也可以访问 https://ollama.com/library 和 https://huggingface.co/models 查看可用模型的列表。

拉取模型: 通常情况下,你可以在命令行中(windows下按win+R键输入cmd进入)使用以下命令来进行拉取

ollama pull <model-name>

运行大模型

启动模型: 使用以下命令启动你下载的模型(如果使用该命令时模型还未下载会直接进行下载)

ollama run <model-name>

与模型交互: 模型启动后,你可以直接在终端中输入文本与模型进行交互。模型会生成响应并显示在终端中。

配置环境变量

打开设置 → 系统 → 关于 → 高级系统设置 → 环境变量 → 系统变量

新建

OLLAMA_HOST值为0.0.0.0添加

OLLAMA_ORIGINS值为*重启系统并允许程序通过防火墙

请注意!配置完环境变量后局域网内的设备都可以访问你部署的ollama,请做好防护。

- 0

- 0

-

分享